Archiv für die Kategorie „Künstliche Intelligenz“

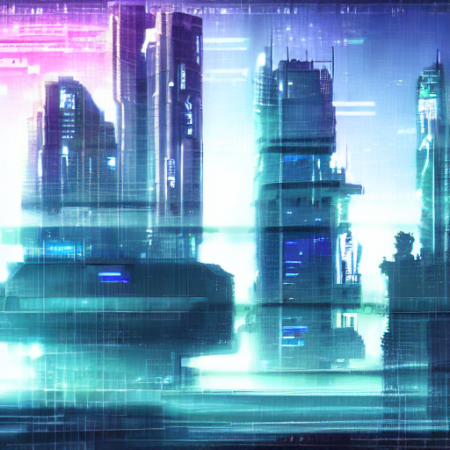

My laptop CPU became an artist over night:

What we see here is actual unique artwork my CPU created over a timeframe of approx. 12 minutes. The only thing I input to was the text string a cyberpunk cityscape and let Stable Diffusion do the rest. It’s beautiful and detailed. I actually love it!

Stable Diffusion is a sophisticated, brand new deep learning model by Stability.ai. It’s already on par with the earlier released, proprietary AI image generators DALL-E 2 or Imagen. With a powerful difference: you can actually create AI images yourself for free on your local machine. Usually done by your GPU, or like in my case above, your CPU, if capable.

I put four hours of work into it yesterday to setup my machine and create more artwork. My CPU came up with more beautiful cyberpunk cityscape examples with the following text string, a cyberpunk cityscape in neonlights at night, see the gallery here:

- a cyberpunk cityscape in neonlights at night

- a cyberpunk cityscape in neonlights at night

- a cyberpunk cityscape in neonlights at night

- a cyberpunk cityscape in neonlights at night

- a cyberpunk cityscape in neonlights at night

I’m lucky to own a powerful notebook CPU from 2020 with a graphics processor built in. I don’t know if this made a difference or not, the results surely are true for what I anticipated and surpassed my expectations.

But how can you join the CPU AI image generation yourself?

I had time to write it down yesterday and am happy to share it here for free for anyone who might be interested to do this with her/his Linux machine.

Step 0: Create a working directory in your /home

Step 1: Install Python

sudo apt-get update*

yes | sudo apt-get install python3.8*

*could be the installation of Python 3.8 is different to the one mentioned above. In this case just use your package manager of your Linux distribution to get the program installed on your machine.

Step 2: Install Miniconda

wget https://repo.anaconda.com/miniconda/Miniconda3-py38_4.12.0-Linux-x86_64.sh

bash Miniconda3-py38_4.12.0-Linux-x86_64.sh

Step 3: Clone the Stable Diffusion Repository

git clone https://github.com/CompVis/stable-diffusion.git

cd stable-diffusion/

Hint: Repo above only works for graphics cards >= 7GB (V)RAM! Thus…

Step 4: Download the ZIP, extract, copy and paste the contents following optimised version of Stable Diffusion in the folder above:

https://github.com/basujindal/stable-diffusion

Step 5: Create Conda Environment

conda env create -f environment.yaml

conda activate ldm

Step 6: Download Stable Diffusion Weights

curl https://www.googleapis.com/storage/v1/b/aai-blog-files/o/sd-v1-4.ckpt?alt=media > sd-v1-4.ckpt

Step 7: Content blocker deactivation (needed in case your output images are green or black only)

* find and open file pipeline_stable_diffusion.py

* below image = image.cpu().permute(0, 2, 3, 1).numpy() replace anything with this and save the file:

# run safety checker

#safety_cheker_input = self.feature_extractor(self.numpy_to_pil(image), return_tensors=“pt“).to(self.device)

#image, has_nsfw_concept = self.safety_checker(images=image, clip_input=safety_cheker_input.pixel_values)if output_type == „pil“:

image = self.numpy_to_pil(image)#return {„sample“: image, „nsfw_content_detected“: has_nsfw_concept}

return {„sample“: image, „nsfw_content_detected“: False}

Step 8: Generate AI images with the CPU

python optimizedSD/optimized_txt2img.py –device cpu –precision full –prompt „a cyberpunk cityscape“ –H 512 –W 512 –n_iter 1 –n_samples 1 –ddim_steps 50

That’s it! By default you find your created images in the outputs folder. You can enter your deserved text string in „“ and let your machine do the rest. Feel free to share some of your works in the comments if this tutorial helped you.

P.S.: I also had the chance to create GPU images yesterday with this method. The only difference is by removing the part –device cpu from the command line code you find in step eight. It will be much faster but to me the option to let your CPU create actual artwork was very much appreciated and may not be well known for future AI generation images through Stable Diffusion. I had some very nice results. Will share more of my work in future entries here on gizmeo.eu so stay tuned!

In der Diskussion um die derzeit in weltweiten Schlagzeilen kursierende Pseudo-KI LaMDA aus den Forschungslaboren Googles geht es um keine wirkliche Künstliche Intelligenz, weil es „wirkliche künstliche Intelligenz“ nicht gibt (siehe hierzu), zumindest aktuell. Und wahrscheinlich noch auf Jahrhunderte hinaus.

Die Software ist aber auf eine andere Art und Weise interessant, doch um die Anfänge zu verstehen muss man weit zurück gehen. Bis ins Jahr 1966 und zum alten (M)IT-Mastermind Joseph Weizenbaum nämlich.

Er nannte seinen Chatbot (auch wenn seine Software 1966 noch nicht so genannt wurde) ganz sexy und selbstbewusst ELIZA. Und ELIZA konnte bereits erste Menschen in die Irre locken, sie sei ein Bewusstsein, weil sie auf Fragen irgendwie vorgekaut reagieren konnte, was dem Bot in einer Datenbank bereitgelegt wurde. Nach dem selben Prinzip funktioniert LaMDA. Menschen waren schon immer sehr dumm und Computer extrem schwer zu verstehen. Tut mir leid.

Was wir aus LaMDA und dem flüchtenden konfusen Ex-Google-Mitarbeiter ableiten können für uns ist Folgendes:

1) ELIZA ist mittlerweile auf dem Stand eines siebenjährigen Menschen

2) es ist immer noch ein Bot und spuckt aus, was du ihm vorkaust

3) es besitzt keinerlei eigenes, gar künstliches Bewusstsein

4) es wird in Zukunft möglich sein Bots so zu programmieren, dass sie ein bestimmtes Alter vortäuschen können, da sie individuell mit entsprechenden Daten gefüttert werden können

Zu Punkt 4) noch eine persönliche Anmerkung, dass wir einen Schritt weiter zu wirklich funktionierenden Chatbots sind dank Google, die eventuell sogar mit Alter und Background programmierbar sein werden und eventuell sogar kostenlos bis wenig kosten werden.

Aber um eine „edle Version“ zu bekommen, die wie eine „wirkliche KI“ funktioniert und sogar VIP-Status(!) hat, wie bereits simuliert(!) in diversen „Deus Ex“-Videospielen gesehen (sie heißt dort, exakt in Anlehnung an Weizenbaums revolutionieren ersten Bot Eliza Cassan) werden wir entweder noch sehr lange warten müssen oder eben weiter zocken, denn mit Realität hat das leider nichts zu tun. Warum da jemand flüchten muss vor leuchtet mir aus IT-Sicht nicht ein. -.-

Oben: selbst als virtueller Charakter der Realität nach wie vor haushoch überlegen – VIP und News Anchor Eliza Cassan

This is a robotic study which is cool and sad at the same time:

„Plan Bee“ is a robotic drone industrial design study by Anna Haldewang to replace real bees by robotic ones if they go extinct so they can pollinate flowers. And extinction can go quick, unfortunately.

There! There it is again! We solve nature’s problems by technology! What can go wrong!?

Single shares of the graphics card company Nvidia are at a whopping 657€ at the moment. Read here why it’s still a very good purchase currently if you’re planning on a long-term ROI (return on investment) regarding 10-15 years in the future.

Above: a Tesla/NVIDIA GPU cluster

1) AI development: Nvidia is one of the forerunners on the development of AI, Artificial Intelligence. Not only is this an industry sector which will be transformative unlike any other for the current century (and maybe more ahead), they offer concrete hardware for development already. If you’re interested in learning it for yourself, look out for „TensorFlow“ keywords or „Tensor core hardware“ here. Equipment is available for a few hundred bucks already

2) the ARM deal: although it can be taken as a hostile takeover, the purchase of British CPU company ARM, which is currently still under investigation, will be a pusher for the company like no other before. Maybe Nvidia may be late in the game but what they lack is the CPUGPU symbiosis competitor AMD can already offer since the ATI deal back in the 2000s

3) cryptocurrency mining: obscure as this may sound, Nvidia graphics cards are among the best for cryptocurrency mining, especially popular ones like Ether. Oh, and they are a good for gaming too!

4) as long as this pandemic may last, people will play video games. And those gamers need those graphics cards, the sooner and the more popular (thus more expensive), the better

Then there are the incredible company vitals, financial aspects are the most important if you plan to invest your hard earned money into a company.

Get that: fiscal first-quarter revenue soared 84% year over year to $5.66 billion. Gaming revenue doubled to $2.76 billion. Data center revenue 79% up to $2.05 billion. Earnings per share 106% year over year to $3.03. All of the mentioned figures which was even better as prognosed by the experts in this field (lower revenue and non-GAAP earnings per share of $5.41 billion and $3.28, respectively). [via]

What the company wants to do now, as is the trend in the high-tech industry sector since the pandemic began (e.g. Apple and Tesla did this too), is to split its stock and double it in sum (from 2 billion to 4 billion), which was announced in May and approved by the share holders some weeks later. Date will be the 20th of July by a ratio 1:4; which basically means, if you hold a share in Nvidia by 19th of July, you will own 4 the day afterwards.

Companies do this for a couple of reasons, some of the most popular ones are „we are overvalued, we now help ourselves“ or „we want to enable the small investors to get a piece of us by lowering the entrance bar“. Both of it is certainly true, we shouldn’t forget though publicly listed companies want to earn more money which will certainly also happen in the case of Nvidia, albeit not in the first months or first year after split. But possibly in years and years to come afterwards. Plus, the last split Nvidia did was in 2006; as you might see easily you can become a part of history here as this will certainly not be the case for years, maybe decades, to come.

Thus fear not to get active if you can spare a few hundreds of Euros but do it quick: latest tomorrow or maybe even by July 19th which is Monday, as this is the final date the stock split goes ex-dividend. The latter translated means: sources which state that you need to hold an Nvidia share by June 21 2021 already are simply false. That is the only quirk here which was announced at Nvidia’s annual meeting of stockholders on June 3. A bit confusing, but hey: it was never easy to earn money in the real world anyway, right?

Hint: I’m not affiliated with the stock market or the company I wrote about in this article. I’m just an IT expert and want to share an important insider information about a graphics company I know since a little child. 🙂

Software.

Hardware.

Made in USA.

Nothing they create is Excellent.

Most of it is Good.

Sometimes even Very Good.

In any case, good is best.

Never try to be excellent. You will fail.

Never stop reaching for the stars.

Never stop being you.

Consume.

Adapt.

Create.

Feel good.

It sounds simple.

It’s incredibly difficult.

Just like life.

Just create. And never stop.

Never.

You’re good.

Wer mag sie nicht, unsere kreativen US-amerikanischen „Nachbarn“: „The U.S. Is One Step Closer to Establishing a Research Program to Block the Sun“, via gizmodo.

Die feiern das: das ist McDonalds gegen den Klimawandel; das in asiatischen Ländern von Kinderhänden gefertigte Nike für das CO2-Problem der Erde; die Killer-Smartphone-App, die alles kann gegen die Schmelze der Arktis. Das funktioniert ganz bestimmt!11

Ironie der Geschichte, dass selbst Hollywood, also das US-eigene Propagandaministerium für die vividen Träume der westlichen Welt, das nicht nur 2003 bereits vorwegnahm, sondern auch das Scheitern des selben. Wir präsentieren, Operation Dark Storm, animiertes Geoengineering, wenn auch zu einem anderweitigen Zweck:

Quelle: „Animatrix“, (C) WarnerBros, 2003

We solved it, now clap your skully hands, suckers!

¯\_(ツ)_/¯

Wer hochwertige Gadgets möchte, der kauft bei Samsung. Wer schon mal einen Sony Bravia-TV auseinandergebaut hat oder ein iPhone, hier sind Teile von Samsung verbaut. Chips, Displays, Inverter – you name it.

Doch auch als Innovatoren können die Südkoreaner sehr gut, ihr neustes vielversprechendes Hardware-Bauteil: ein KI-RAM.

Intern nennen sie es FIMDRAM, im Detail schaut der Die (Halbleiter-Waferstückchen) dann so aus:

Praktisch haben sie wohl „einfach“ programmierbare Recheneinheiten (Programmable Computing Units (PCU)) zwischen die Speicherbänke verbaut. Die können zwar aktuell lediglich 16-bitige Fließkommazahlen verarbeiten und verfügen nur über einfache Instruktionen (Daten verschieben; Multiplikation; Addition). Dennoch clocken diese mit 300MHz – was einer Leistung von 1,2 TFLOPS entsprechen soll. Das ist enorm: zum Vergleich, das gesamte PS4-System (keine Pro-Version) bringt 1,84 TFLOPS Leistung…

Samsungs neuartiger RAM im Detail (PPTs): https://m.gsmarena.com/samsung_creates_ram_with_integrated_ai_processing_hardware-news-47794.php.

Hardwareseitig könnte man effizientere KI-CPUs wohl aktuell nicht bauen. Die Latenzen sind hier sehr gering, ferner verbrauchen die Chips 71% weniger Energie. Ein Wermutstropfen bleibt aber noch: nicht nur wird das Design erst diese Woche bei der International Solid-State Circuits Virtual Conference von den Südkoreanern der Weltöffentlichkeit präsentiert. Die Validierung von Experten wird noch mindestens bis Juli dauern. Mit etwas Glück erscheinen diese speziellen neuen KI-RAM-Riegel dann wohl Ende dieses Jahr/Anfang 2022 in Hardware, die man als 0815-Konsument kaufen und programmieren können wird.

Ein Wendepunkt in der Programmierung künstlicher Intelligenz? Könnte sein. Ich persönlich traue es Samsung durchaus zu.

Mit einer ähnlich hohen wissenschaftlichen Relevanz wie 1996 mit dem Schachcomputer „Deep Blue“ gegen Schachweltmeister Garri Kasparow, so hat exakt 20 Jahre später ein Computerprogramm, „AlphaGo“, den südkoreanischen Großmeister des asiatischen Strategiespiels Go, Lee Sedol, geschlagen.

Eine Dokumentation in Spielfilmlänge (ca. 90 Minuten), die mittlerweile frei und kostenlos im Internet erhältlich ist, kann man sich hier anschauen:

Eigentlich galt Go bis zu diesem Zeitpunkt als von einer KI (künstlichen Intelligenz) „unknackbar“, hat es nicht nur mehr Felder pro Brett (19×19, statt 8×8), sondern lässt in Theorie mehr Züge zu, „als es Atome im Universum gibt“. Ferner ist es durch reines Herumprobieren, dem sogenannten Brute Forcing, auch nicht im Voraus berechenbar.

Es stellte sich heraus, für die Künstliche Intelligenz mussten nicht nur neue Algorithmen her (in diesem Fall der Monte-Carlo, da er mit Zufällen arbeiten kann), sondern gleich ein komplett neues neuronales Netz, das tiefe neuronale Netzwerk. Nach 9 Jahren Forschung wollte die Firma DeepMind dann genauer wissen, was die Eigenentwicklung wirklich drauf hatte: Sedol verlor vier von fünf Spielen.

Der Film ist nichts für Philanthropen, bietet allerdings neben interessanten Einsichten in menschliche Psychen auch viel Wissenswertes zum Thema Informatik und künstliche Intelligenz allgemein. Man darf gespannt sein, wo man hier 2036 angekommen sein wird; wer/welche Firma das Programm stellt; und welches Spiel die Menschheit noch für immer verloren geben muss (siehe auch: Der Alpha-Go-Schock und die Folgen, 22.12.16).

*…klaut die Stimme von Marsimoto, der sie von Quasimoto geklaut hat, am Ende ist es auch einfach nur eingeatmetes Helium, weil den Schallwellen gefällt das, und legt dann mal los…*

Keiner kümmert sich um GPUs/

Wie geht es deiner GPU/

Frag‘ dich: was macht Klicki-Bunti-Grafik/

Es ist deine GPU, sonst nix/

STRG+Escape, die GPU taucht da nicht auf/

wieso denkt der doofe Coder, dass ich GPU nicht brauch/

CPU, RAM, mein Benutzername, Tabellenansicht/

wieso sehe ich die Prozentzahl meiner GPU nicht/

meine GPU macht mir Grafik, das ist wichtig/

meinem Pinguin fehlt ohne GPU sein Gesicht/

CPU ist das Gehirn, GPU schiebt die Optik/

Pink und Rosa – GPU, sonst nix/

Keiner kümmert sich um GPUs/

Wie geht es deiner GPU/

Frag‘ dich: was macht Klicki-Bunti-Grafik/

Es ist deine GPU, sonst nix/

Windows, Linux, Unix – alles braucht hier Grafik/

wieso sehe ich nach Reboot GPU-Temperatur nicht/

Was heißt „off“, wieso hier Reload mit rechter Maustaste/

ohne GPU nützt mir Temperatur-Widget nix/

Treiber-Treiber, immer Treiber, offen oder proprietär/

Hauptsache „Diablo“ läuft, denn was nützt hier „Solitär“/

Laptop, PC, Smartphone oder Tablet/

ohne GPU kein einziger Pixel hier, nix fett/

Keiner kümmert sich um GPUs/

Wie geht es deiner GPU/

Frag‘ dich: was macht Klicki-Bunti-Grafik/

Es ist deine GPU, sonst nix/

Helfer-Tool hier, Helfer-Tool da/

der Aufwand für jede GPU – immerda/

das Erste, was ich an neuer Hardware einrichte/

ist GPU, weil der Rest läuft bereits aus der Kiste/

„out of the box“, IT, wie sie immer sein soll/

wieso funktioniert GPU nicht, was hat sie euch getan/

liegt es vielleicht an AMD oder NVIDIA/

oder Apple, oder ARM, vielleicht auch C&A/

Keiner kümmert sich um GPUs/

Wie geht es deiner GPU/

Frag‘ dich: was macht Klicki-Bunti-Grafik/

Es ist deine GPU, sonst nix/

Meinen Stromanbieter, den freut’s/

denn heute mine ich auf GPU die Kryptocoins/

Warnschild rot, die GPU schon über 90 Grad/

warum ist Geld verdienen hier so hart/

die GPU, ja sie macht die Träume wahr/

Traumfabrik in Plastik, wir sind so smart/

und jetzt auch die KI für ein paar Hunderter/

übermorgen fliegt mich GPU zum Mars, sonnenklar/

Keiner kümmert sich um GPUs/

Wie geht es deiner GPU/

Frag‘ dich: was macht Klicki-Bunti-Grafik/

Es ist deine GPU, sonst nix/

ich schalte das Teil ab, GPU muss sich schlafen legen/

sie lief zwei Wochen durch und muss nun Updates regeln/

hoffentlich ist nach Reboot meine GPU noch da/

bei shutdown -r now denke ich über Heirat nach/

doch was ist das, ist es ein Fussel oder doch ein Haar/

wie Schuppen von den Augen wird mir dann plötzlich klar/

Mist, schon wieder zwei Zentimeter Schicht drauf/

ich muss das Ding erstmal jetzt abstauben/

Keiner kümmert sich um GPUs/

Wie geht es deiner GPU/

Frag‘ dich: was macht Klicki-Bunti-Grafik/

Es ist deine GPU, sonst nix/

2047. Eine App namens Infinitalk ermöglicht die Kommunikation mit Verstorbenen. Realisiert wird das durch ein KI-System in einer Cloud, das zuvor über ein Implantat hinter dem Ohr das gesamte restliche Leben der Teilnehmer aufgezeichnet hat. Die verstorbenen Menschen existieren weiter als digitale Entität, mit all ihren Fehlern und Vorzügen, Umgebungen, etwaigem Mobiliar und Gerätschaften.

CEO Linus (gespielt von Friedrich Mücke) sitzt gerade zusammen mit seinen drei weiteren Gründern des Startups, CTO und Hacker Bahl (Aram Tafreshian), Marketingleiter Malik (Jan Krauter) und seiner Ex-Verlobten Luca (Laura de Boer) in einem Hotel in Tokio, um den Verkaufs-Deal der App an den japanischen Investor Linden Li (David Tse) durchzuziehen. Li will die Applikation mit seinem Hologramm-Imperium verknüpfen. So soll die Kommunikation mit den Verstorbenen in Zukunft der Realität so nah wie möglich sein. Selbstredend würde der Deal alle vier zu Multimilliardären machen, was sich v.a. Malik bereits sehr gut vorstellen kann. Luca allerdings hat etwas dagegen. Sie vertraut Li und seinem Imperium nicht, sondern lieber auf ihre Intuition, die nichts Gutes verheißt. Als sich alle aus ihrem virtuellen Meeting wütend und ohne finale Unterzeichnung des Vertrags verabschiedet haben, verschwindet am nächsten Morgen Luca plötzlich spurlos.

Was wie ein Wirtschaftsthriller beginnt entwickelt sich im Laufe von nur 90 Sendeminuten („Exit“, ARD, Erstausstrahlung war am Mittwoch, 28.10.20, 20:15) zu einer dystopisch erzählten Geschichte der Wahren Liebe auf engstem Raum: das Hotel selbst wird in den seltensten Fällen verlassen, alternative Schauplätze sind entweder Rückblenden oder spielen sich in einem weißen, endlos wirkenden virtuellen Raum ab. Anleihen an „The Matrix“ aus 1999 sind durchaus gewollt und wirken überzeugend, sofern man von den Hacking-Tools symbolisiert durch Baumarktwerkzeuge einmal absieht. Auch sonst ist das dystopische Jahr 2047 in Tokio, das uns die ARD mit unseren hart verdienten GEZ-Gebühren auf die Flimmerkisten unserer Wohnzimmer zaubert, durchaus auf Niveau eines Hollywood-Cyberpunk-Blockbusters wie „Blade Runner“ (1982). Entsprechende Hausaufgaben wurden also gemacht, angefangen vom Interieur des Hauptschauplatzes, über die Hightech-Utensilien, die die Protagonistinnen und Protagonisten bei sich tragen, bis zur düsteren minimalistischen Musik und allen verwendeten Grafiken. Das muss und sollte man hier hoch anrechnen.

Nicht so gut bei mir kam hingegen die Überladung der Themen, sowie die zu großen Gemeinsamkeiten und das Mindfuck-Moment des Films zu „Welt am Draht“ an – hier hätte ich mir mehr Diversifikation gewünscht. Man merkt dem Stoff an, dass er hoffnungslos verkopft ist. Das mag zum einen an unserer deutschen Mentalität, zum anderen am derzeitigen Hype um Netflix liegen – denn hier hätte man ohne Probleme eine sechsteilige Miniserie daraus bauen können. Vielleicht war es auch so gedacht, man wollte es den betagten Standardzuschauern der ARD aber am Ende ersparen; der ich sicher keiner bin, schon aus Altersgründen. Es wären auch noch andere Themen als die Lovestory als Handlung und eine Wendung zum Ende in Frage gekommen, die eben nicht an Fassbinders Standardwerk aus 1973 erinnern. Wobei: wer erinnert sich aus meiner Generation wohl an „Welt am Draht“? Oder kennt es überhaupt? Eben. Niedriges Risiko.

Wer sich als Cyberpunk bezeichnet, der sollte diesen Film mögen und wird ihn sich ansehen müssen. Zumal man hier nebenbei ganz starke Schauspielerinnen- und Schauspieler-Leistungen zu sehen bekommt – kein Wunder, die Besetzung hat tiefe Wurzeln in der wertvollen Kulturleistung Theater. Schön, dass die deutschen Rundfunkanstalten (zumal aus meiner Gegend, sogar der SWR) auch mal eines meiner liebsten Genren abdecken! Ich selbst konnte mich jedenfalls nicht erinnern, wann ich mir das letzte Mal einen Kalendereintrag für eine Fernsehübertragung gesetzt hatte, die auch noch nicht live ist. Großes Kino, hat sich gelohnt! Aber auch zeitweise ganz schwere Kost für gute Nerven.

8/10

Man kann von Tesla halten was man will: US-amerikanische Marke; Verarbeitung nicht so gut wie bei deutschen oder japanischen Modellen; Akku brennt; der Gründer ist ein (Cov-)Idiot; Markennamen von einem bedeutenden europäischen Erfinder geklaut; etc. pp. You name it.

Aber eines kann man ihnen nicht vorwerfen: der Wille zur Innovation.

Bei Tesla träumt man Innovationen nicht nur oder zeichnet diese. Sie werden in Realität gesetzt. Und dabei haben sie anderen Firmen auf dem Planeten manches voraus. So z.B. ein fahrbares und nutzbares E-Automobil. Und ein zukunftsfähiges Konzept insgesamt. Ja, wahrscheinlich DAS Zukunftskonzept der Mobilität überhaupt für die nächsten Jahrhunderte. Und das „schon jetzt“.

Deshalb lohnt es sich genau jetzt in Tesla-Aktien zu investieren: durch den Split ging der Preis pro Aktie nämlich fast über Nacht von über 2.200$ runter auf aktuell 360€. Wer also ein paar Hunderter übrig hat, das sollten einige Menschen sein seit März, auch unter meinen Leserinnen und Lesern, der sollte sich (ein Depot eröffnen und) Aktien dieser Firma kaufen. Es ist sehr wahrscheinlich, dass die 1.000€ wieder schnell geknackt sein werden. Dann hätte man alleine durch eine Beteiligung fast das Dreifache wieder drin. Ende ist hier übrigens nach oben offen.

Man kann das Geld schnell mitnehmen oder halten. Ich würde halten. Einfach aus „Prinzip Zukunft“. Und es gibt da noch etwas, was ich bemerkenswert fand, die Meldung ist aber schon ein paar Monate her.

Wie wir alle wissen sind oder waren die Japaner mal das technologisch am weitesten fortgeschrittene Völkchen der Erde. So stark und so mächtig und sehr weit fortgeschritten, sie galten als „Schwan“ und flogen in Gesamtasien voraus, während andere Länder wie Südkorea, sogar Taiwan und China, hinterher wackeln mussten. Irgendwann in den 80ern war das so. Es mag sich mittlerweile gewandelt haben, ich bin auch der Meinung, insgesamt haben wir „alles schon erfunden“, also da wird kaum noch was Neues kommen für die Menschheit. Und das wechselt sich da unten nun munter ab, wer in der Parabel voraus fliegt. Ich tippe ja aktuell auf Südkorea, China braucht noch ein paar Jahre, vielleicht Jahrzehnte. Wobei man Taiwan mit dem Chipfertiger TSMC hier auch nicht vergessen darf.

Ich schweife ein bisschen ab, denn was ich eigentlich erzählen will kann man auch ohne dieses Wissen und die Vogelzug-Parabel faszinierend finden.

Die Japaner haben nämlich vor wenigen Monaten den Tesla Model 3 komplett zerlegt, die Ergebnisse wurden im Februar der Weltöffentlichkeit präsentiert. Denn was machst du als Hacker erst einmal, wenn du neue Technik verstehen willst oder schauen möchtest, ob die Technik wirklich neu ist? Na klar, du baust sie auseinander!

Das Wichtigste und das Unbekannteste, das sie fanden, waren zwei individuell designte KI-Chips, von Tesla komplett selbst entwickelt(!), mit entsprechend inhouse-entwickelter Software:

Oben: der Computer des „Model 3“ – ein KI-Chip regelt das autonome Fahren, der andere das gesamte Infotainment-System

Im Kern fanden die Japaner heraus, „ja gut, das Hardware-Ensemble ist eben dafür gut, dass dieses Auto sich selbst steuern kann und die massive Infotainment-Anlage“. Und das stimmte dann auch. Doch was noch viel bedrückender war aus der Sicht der japanischen Ingenieure:

Die Hardware, die oben zu sehen ist, ist 6 Jahre ihrer Zeit voraus!

Tesla ist damit nicht nur Konkurrenten zeitlich enteilt, Tesla ist mit dieser Hardware einer kompletten Industrie enteilt.

„But technological hurdles are not the reason for the delay, according to the Japanese engineer who said „we cannot do it.““

Einer Industrie, die in Europa alleine 3,65 Millionen Menschen beschäftigt – bei Tesla arbeiten aktuell nur 48.000 (Stand 2019)…

Das ist „Alien-Sh*t“, was wir hier sehen. Solche Technik dürfte es aktuell gar nicht geben.

2019 nicht.

Dieses Jahr nicht.

Nächstes Jahr nicht.

2022 nicht.

2023 nicht.

2024 leider auch nicht.

Maximal „irgendwann 2025“, sagen Industrie-Insider. Denn auch wenn der Bericht Ende Februar publik wurde, auseinandergenommen wurde der Tesla wohl irgendwann Ende 2019.

Ganz ehrlich: WAS haben die da gebaut!? und WIE!? Ich bin kein reiner Ingenieur, aber ein kleiner CPU-Head. Vor solch einer Leistung habe ich irre Respekt. Und leider auch Angst.

Und sehen wir es realistisch, selbst wenn sie mit Autos als Konzept komplett sich zerlegen würden, sie hätten immer noch diese Chips, also konkrete Hardware, sowie maßgeschneiderte Software dazu im Angebot. Mir würden spontan mindestens ein Dutzend Anwendungsfälle dazu einfallen, „I, Robot“ wäre Kindergeburtstag dagegen.

Der hier und seine KollegInnen lauschen pro Tag bis zu 19(!) mal „zufällig“ in Gespräche rein:

Meldungen über zuhörende „smart speaker“ gab es in den letzten Jahren so einige, genauere Untersuchungen oder gar wissenschaftliche Studien dazu eher weniger.

Mittlerweile hat sich das geändert und auch die Untersuchungen laufen sogar noch weiter, siehe: https://moniotrlab.ccis.neu.edu/smart-speakers-study/, Universität Boston NE. [via]

Kam heraus: im Schnitt lauschen „smarte Lautsprecher“ wie Alexa, Google Home & Co. satte 19-mal „zufällig“ pro Tag in die Gespräche rein. o.O

Für die Versuche wurden alle Geräte in eine kleine Box geschlossen und satte 125 Stunden mit Streaming-TV-Audio vollgepumpt. Gemessen wurde dann, wann die Devices aktiv werden, im Techsprech „aufwachen“. Das kam bis zu 19-mal innerhalb eines 24-Stunden-Zyklus vor. Am schlimmsten am Lauschen waren die Geräte von Apple und Microsoft in den Tests. Für den letztgenannten Hersteller und Amazon gab es auch die längste „zufällige“ Aufnahme, satte 43 Sekunden am Stück.

Spannend werden die zukünftigen Untersuchungen der Inhalte in die jeweiligen Hersteller-Clouds: hier will man zum einen wissen, welche das genau sind. Und zum anderen, ob diese vorurteilsbehaftet sind, also Unterschiede aufweisen bezüglich Geschlecht, Ethnie oder Akzent.

Ferner ist bisher nicht bekannt, ob die „Smart Speaker“ aus ihren Fehlern lernen, also über irgendeine Form von künstlicher Intelligenz verfügen. Wobei man sich bei machine learning, was hier Anwendung finden würde, auch bis heute streitet, ob man hier überhaupt KI am Werk sieht. Auch hier werden die Ergebnisse mit Spannung erwartet.

Talking about „smart“, eh!?

Es gibt Todesfälle von Künstlern, die will man nicht (wahr) haben.

Einfach, weil es absolute Ausnahmetalente ihres Fachs waren.

Oder weil sie einen selbst geprägt haben wie kaum weitere.

Für mich war Syd Mead beides.

Ein Genie, der „meine“ Cyberpunk-Welten so visualisieren konnte, wie ich sie am liebsten hatte: realistisch, düster, farbenfroh & kraftvoll.

Schnappschuss von heute, 3.2.20, der offiziellen Website sydmead.com.

Syd Mead verstarb bereits am 30. Dezember 2019 im Alter von 86 Jahren. Seine letzten Worte sollen gewesen sein: „Ich bin hier fertig. Sie kommen und holen mich zurück.“

Syd, wherever you went, farewell! You’ll surely be missed! Thanks for your patience in creating those worlds. And also for your courage in publishing those. I don’t think your place will be replaced easily. Requiescat In Pace, dear old cyberpunk friend!

Empfohlene Links:

http://sydmead.com/ – offizielle Website

„The Movie Art of Syd Mead: Visual Futurist“ (Englisch) – Gebundenes Buch, 28,99€, amazon.de

Meldung des Todes von Syd Maed – über dezeen.com, 02.01.20

„In Memory of Syd Mead: The Grandfather of Concept Design“ – via artstation.com

„The Art of Syd Mead“, via iamag.co

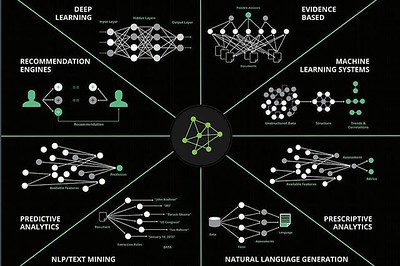

(Oben: Forschungsbereiche der künstlichen Intelligenz, CC0 Paula Piccard)

Den Spezifikationen nach hat man bei der KI-Text-Software GPT-2 alles richtig gemacht:

* 1,5 Milliarden Parameter

* Datensatz von 8 Millionen Webseiten als Grundlage

* einfach gestecktes Ziel: Vorhersage des nächsten Worts in einem 40GB-großen Internet-Text

Entstanden ist so „das Modell einer unbeaufsichtigten Sprache, das allgemeinverständliche Textpassagen mit einer guten Performanz und einem rudimentären Leseverständnis, sowie Maschinenübersetzung, Fragestellung und Zusammenfassung“ (Quelle: https://openai.com/blog/better-language-models/) in sich vereint.

Als wissenschaftlicher Mitarbeiter des Planeten Erde ein „Hut ab!“ von mir und Respekt, dass es im Jahr 2019 solch eine Software gibt! Das war eine News im Februar.

Daraus entstanden ist ein regelrechter „Shitstorm“. Denn paranoide Zeitgenossen und Skeptiker witterten darin „ein bereits einsetzbares Programm zur Verbreitung von Fake News, Spam und Desinformation“ (via).

Mittlerweile haben sich die Gemüter wohl beruhigt. Und OpenAI, ein gerade mal vier Jährchen junges Startup aus San Francisco, war die Sache dann zu blöd, die haben die Vollversion der Software letzte Woche kurzerhand öffentlich gemacht.

Von nun an sollten wir alle in der Lage sein, theoretisch, z.B. durch die Eingabe einer beliebigen Überschrift, uns einen entsprechend sinnvollen Text generieren zu lassen. Oder umgekehrt. Und noch viel mehr.

Um zu verstehen, wie das System funktioniert, muss man der englischen Sprache mächtig sein und kann dann mal live hier ausprobieren, worum es geht:

https://talktotransformer.com/.

Einziger Wermutstropfen: die Dropdown ist bereits vorausgefüllt. Trotzdem: nettes Web-Gimmick mit Potenzial!

„The Verge“ hat in einem entsprechenden Artikel natürlich allerlei Nachteile entdeckt: die Verwendung von Namen durchgängig im Text sei nicht kohärent; das System bleibe in einem Nachrichtenartikel nicht beim Thema; solche Sachen. Doch ganz ehrlich: das machen Menschen auch und irgendwo kamen ja auch die Millionen Texte her. Das kann durchaus auch erlernt sein, bleibt aber natürlich Spekulation.

„The Verge“ war auch eines von vielen US-Onlinemedien, denen gar nicht so wirklich wichtig war, was hier genau Revolutionäres passiert. Viele Passagen im Artikel dort widmen sich einer laufenden US-Debatte, ob KI-Forscher Schaden anrichten oder nicht und ob denen das bewusst ist. Ich will da auch nicht weiter darauf eingehen, weil da sind auch wieder so hässliche Themen dabei. Kurzes Fazit: in ~95% der Fälle wissen die OpenAI-Mitarbeiter wohl selbst, ob ein Text ein GPT-2-erstellter ist.

Für mich hingegen ist eigentlich nur wichtig: wann geht denn jetzt Eliza Cassan endlich auf Sendung in meiner Glotze!?

Im Alter von 75 Jahren ist der niederländische Schauspieler, und eine _der_ „Blade Runner“-Kultfiguren, Rutger Hauer, diese Woche verstorben.

[via]

Wer mich persönlich kennt, der weiß um meine starken Prägungen als Cyperpunk durch den Kultfilm aus meinem Geburtsjahr 1982, sowie durch das Videospiel 1997. Vieles von dem, was dieses filmische Spektakel erst zu einem Kultfilm gemacht hat, wäre ohne Rutger Hauer gar nicht möglich gewesen.

Oben: Rutger Hauer 2007 bei einem Workshop in Rotterdam

Ein Beispiel ist der Monolog, den die Filmfigur und Replikant Roy Batty zum Schluss hält. Den hat Hauer nämlich einfach selbst umgeschrieben und in dieser Perfektion der Figur in den Mund gelegt:

„Ich habe Dinge gesehen, die ihr Menschen niemals glauben würdet. Gigantische Schiffe, die brannten, draußen vor der Schulter des Orion. Ich sah C-Beams, glitzernd im Dunkeln nahe dem Tannhäuser Tor. All diese Momente werden verloren sein in der Zeit, so wie Tränen im Regen. Zeit … zu sterben…“

Zeitlose filmische Momente, die einen legendären von einem gewöhnlichen Film unterscheiden.

Mit seinem Tod verliert nicht nur Hollywood sondern auch das europäische Kino einen wahren Charakter, den es so kein zweites Mal mehr geben wird.

Ich verneige mich, natürlich virtuell, wie es sich für einen echten Cyberpunk gehört, und verabschiede mich mit den folgenden Worten:

Requiescat In Pace, Rutger Hauer (1944-2019)!

„Das Licht, das doppelt so hell brennt, brennt eben nur halb so lang, und du hast für kurze Zeit unglaublich hell gebrannt, Roy.“