Archiv für die Kategorie „CPUs“

Das neue Jahr 2018 beginnt mit einem cybersecuritytechnischen Albtraum, der es in sich hat.

Grafik gefunden bei: https://defectivebydesign.org/intel-hdminsult

Im Zentrum des Skandals steht kein Geringerer als CPU-Behemoth Intel.

Erst Ende 2017 wurde bekannt, dass sich Intel-CEO Brian Krzanich von 250.000 Intel-Aktien getrennt hatte. Darüber berichtete am 19. Dezember noch fool.com, sogar mit einem recht neutralen Artikel, dass das mal vorkommen kann. Trotzdem fragte man sich da, was das eigentlich sollte. Zu der Zeit waren bereits über zwei Wochen ins Land gegangen, als ein IT-Team aus Graz in einem Selbsttest eine kritische Prozessor-Lücke fand.

Am 2. Januar, also am Dienstag dieser Woche, sickerte dann durch, was eigentlich nicht sollte: „The Register“ macht publik, dass ein elementarer Designfehler(!) in den Prozessoren von Intel seit 1995(!) dazu führte, dass Kernel-Entwickler über Weihnachten und Neujahr durcharbeiten mussten, um den Bug im Betriebssystemkern zu fixen. Betroffen ist jegliches Betriebssystem, das auf einer Intel-CPU läuft, also mindestens Windows, macOS und auch Linux. Der Name dieses kritischen Fehlers: Meltdown.

Jetzt ist es so, dass man unter Sicherheitsforschern und in der Industrie sich im Geheimen geeinigt hatte, dass entweder gar nicht oder nachträglich publik zu machen. Gedacht waren Updates zum 9. Januar von den Betriebssystemherstellern. „The Register“ hat dem Ganzen einen Strich durch die Rechnung gemacht.

Auf der einen Seite ist das gut so, aus journalistischer Sicht. Auf der anderen steht jetzt erst einmal die Tür offen für Hacker, was aber so ja auch nicht stimmt, denn die Lücke ist Jahrzehnte alt. Und da man Intel mittlerweile sehr gut kennt, kann man auch nicht nachweisen, dass diese Lücke Zufall war.

Was man also über die Feiertage in Angriff nahm, wird nächste Woche frühestens gefixt, das Hauptaugenmerk gilt zuerst Meltdown. Der Haken dabei: betroffene Rechnersysteme verlieren durch das Patchen maximal 30% Leistung.

Es kam aber natürlich noch dicker, denn Intel ist ein schlechter Verlierer.

Neben Meltdown wurde eine weitere Lücke bekannt, Spectre. Und diese ist nicht nur bei Prozessoren von Intel, sondern auch von AMD und ARM anzutreffen.

Meltdown erlaubt es sicherheitsrelevante Informationen aus dem Speicher des Kernels (Betriebssystemkern) auszulesen. Das können Webseiten sein, die man besucht hat, Passwörter, Logins, etc. Spectre hingegen zwingt Programme ihre Geheimnisse freizugeben. Der Bug ist härter zu exploiten, aber auch schwerer zu beseitigen. Spectre dürfte Sicherheitsforscher in der IT noch weit über den Januar hinaus beschäftigen.

Zu der Wartezeit und dem Patchen gibt es keinerlei Alternative. Zwar kann man seinen Prozessor z.B. in einem Desktop-PC austauschen, doch das verhindert das Vorhandensein von Spectre nicht. Was Programmierer hier leisten müssen ist überirdisch: einen Hardwarefehler auf Softwareebene beseitigen. Wer sich ein wenig mit der Materie auskennt, der weiß, dass das physikalisch gar nicht geht. Die Schuld liegt also eindeutig beim US-amerikanischen Chiphersteller Intel. Selbst in Sicherheitskreisen fragt man sich, ob dieser Bug nicht von vornherein ein „Feature“ war. Wenn auch Intel als US-amerikanisches Unternehmen sich an US-amerikanische Vorgaben halten muss. Seit den Enthüllungen von Edward Snowden im Juni 2013 ist hier alles denkbar.

Einen widerlichen Beigeschmack hat darüberhinaus der massive Aktienverkauf von Intel-CEO Krzanich: als das Grazer Team und ein weiteres von Google, die zufällig zur selben Zeit auf den Bug stießen, Anfang Dezember von Intel selbst kontaktiert wurden, wurden diese hellhörig. Man fragte sich, was das große Interesse des Chipriesen hervorgerufen hatte. Spätestens da war klar, auf was die Forscher gestoßen waren. Zwischen dem Bekanntwerden des Bugs intern bei Entwicklern und der Veröffentlichung von „The Register“ lagen keine vier Wochen. Sich noch kurz vor Bekanntwerden eines kritischen Bugs von Aktien des eigenen Unternehmens zu trennen ist nicht nur feige, sondern auch völlig verantwortungslos. Es ist nicht davon auszugehen, dass sich Krzanich so noch länger halten kann, zumal es beim CPU-Megakonzern schon länger kriselt: im November erst schnappte man sich den Grafik-Chef von AMD, Raja Koduri, und machte ihn zum Grafik-Boss bei Intel. Das Ergebnis ist ein Platinen-Bastard, der eigentlich nie denkbar war: mit dem Core i7-8809G erscheint Anfang 2018 die erste Intel-CPU mit einer AMD-Grafikeinheit(!). Es geschehen Dinge hier seit Monaten bei Intel, wo man früher abgewunken hätte. Die sind nicht mehr ganz dicht. Wäre ja nichts Neues.

Ein Moment der Stille für die schizophrenste CPU-Klitsche der Welt.

Indien hat wohl die kompetenteste IT-Workforce der Welt. Und wohl die am meisten unterbezahlte.

Ein neues ambitioniertes CPU-Projekt von dort könnte bald ARM den Garaus machen: Shakti.

Gerne hätte ich ein Bild des Prototypen eingebunden. Oder ein Logo. Einzig: es existiert noch nichts davon. Was ich weitergeben kann ist ein Gruppenfoto des mutigen Projekt-Teams.

Zwei Dinge, die mir imponieren und wo ich großes Potenzial sehe: Open-Source-Hardware. Und basierend auf RISC-V. Gefährliche Mischung! Die schmeckt. Zumindest mir.

Für die Spindoktoren reicht einfach, dass wir Schlagworte und -phrasen wie „IoT“, „Start Frühjahr 2018“ oder „Elektronik ist das Öl Indiens ab 2020“ weitergeben. Ich überlasse es denen, entsprechende „Hashtags“ zu generieren. Ich hoffe und bete, sie kriegen das hin.

Wer gerne tiefer einsteigen möchte in die Materie, ich gebe gerne ein paar nützliche Ressourcen weiter:

*Offizielle Website des Shakti-CPU-Projekts

*Das Shakti-Prozessor-Programm (PDF allerdings aus 2015)

*Open CPU-Projekte auf GitHub, basierend auf RISC-V

*Für was Shakti im Hinduismus steht, Wikipedia

Schön! Gut! Vielversprechend! उंगलियों को पार कर!

Un-glaub-lich:

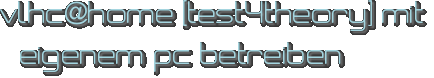

Mit meinem Laptop heute die Marke von 100.000 Partikelkollisionen geknackt! Mit. Dem. Laptop. Ein Modell aus 2011.

Beim BOINC-Projekt ATLAS@Home vom CERN kann jeder die Grafik selbst über den Manager aufrufen, wer daran teilnimmt. Die Ergebnisse der eigenen Simulationen (laufen in VirtualBox und benötigen pro CPU-Thread 4GB RAM) werden dann mit Tausenden anderen zusammengeführt, an universitäre Rechenzentren verschickt und mit den Daten des echten ATLAS-Detektors abgeglichen.

Was man sich dadurch erhofft: eine Abweichung vom Standard-Modell der Physik, wie wir sie kennen. Und dadurch eine völlig neue Physik.

Einzig, bisher sieht es auch dank LHC und ATLAS und CMS nicht danach aus. Immerhin: 2012 wurde das unmöglich auffindbare Teilchen („god damn particle“) Higgs-Boson bestätigt.

Für 100.000 Partikelsimulationen brauchte meine eigene Maschine ca. 14 Monate. Sie lief nicht permanent durch. Schließlich ist das Teil immer noch mein Arbeitsgerät. Trotzdem will ich dem Ding nun erst einmal eine Pause gönnen; für die Hardware sind die ganzen BOINC-Projekte nicht Ohne.

Noch ein letzter Hinweis:

Sowohl das Projekt ATLAS, als auch CMS und ALICE gibt es nicht mehr als eigenständige Projekte seit diesem Sommer. Teilnehmen kann man nun über den LHC@Home-Account. Dort müsst ihr auch selbst an-/abschalten, welche Projekte ihr unterstützen wollt. Ergab Sinn, weil das alles Projekte vom CERN sind. Ich fand allerdings die Kommunikation dieses Umstands ungenügend. Wer noch einen alten LHC@Home-Account nutzt muss den ferner auch auf SSL umstellen. Projekte, die noch Accounts vom LHC@Home nutzen ohne SSL, werden nicht mehr unterstützt. Auch hier bitte selbst prüfen.

Wir bleiben einen Moment bei der komplizierten Materie der Computer-Prozessoren.

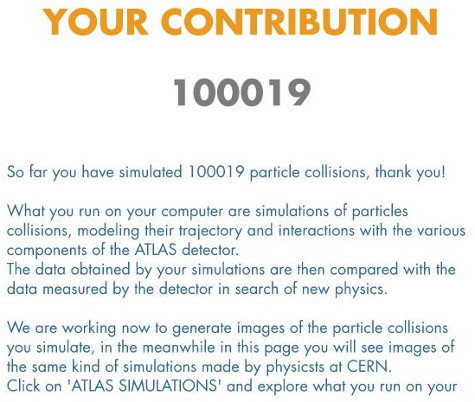

Mit sandsifter finden wir drüben bei GitHub ein ziemlich cooles Tool, das x86-Prozessoren nach Bugs und versteckten Instruktionen absuchen kann.

Hier der Link:

github.com/xoreaxeaxeax/sandsifter.

Ein Standard-Lauf wird nach der Installation folgendermaßen gestartet:

sudo ./sifter.py --unk --dis --len --sync --tick -- -P1 -t

In der oberen Hälfte laufen dann die Schritte, die sandsifter gerade durchführt. In der unteren listet euch das Programm die Anomalien. Wichtig: je nach Geschwindigkeit und Komplexität eurer CPU kann ein Scan mehrere Stunden oder sogar Tage dauern, plant also genügend Zeit für den Test ein.

Sobald alles durch ist, fasst die Ergebnisse mit diesem Befehl in einem Log zusammen:

./summarize.py data/log

Es ist üblich, dass Millionen Instruktionen gefunden werden. Im Kern gibt es aber drei Bereiche, die euch Aussagen liefern sollen zu:

* CPU-Software-Bugs (z.B. im Hypervisor)

* CPU-Hardware-Bugs

* Undokumentierte Instruktionen (Instruktionen, die eure CPU zwar liefern kann, aber vom Hersteller nicht bestätigt werden)

Besonders der letzte Punkt dürfte für Hacker und Hardware-Freaks interessant sein.

Falls ihr Hilfe bei der Analyse benötigt, wendet euch einfach per EMail an den Entwickler und schickt das Log mit: xoreaxeaxeax@gmail.com.

Viel Spaß beim Jagen und schönes Wochenende!

Dank eigener, gigantischer Marketing-Anstrengungen ist AMD mal wieder in aller Munde: mit dem Ryzen müsste es doch end-lich mal klappen dem CPU-Titan Intel Paroli zu bieten!

Mittlerweile kann ich die Jahre nicht mehr zählen, wie oft die Ingenieure von AMD das bereits versucht haben.

In meiner eigenen Erinnerung waren meine AMD-Chips immer zu laut und zu heiß, von daher kann ich mir schwer vorstellen, dass jetzt mit der Zen-Architektur (Ryzen ohne Marketing…) „alles besser werden“ soll. Schlechte Chips hat AMD nie gebaut. Nur ist/war Intel einfach zu mächtig. Und neben dem Windows-Kosmos kam durch Steve Jobs vor wenigen Jahren der Apple-Kosmos noch dazu. Von einem rein technischen Standpunkt heißt das gar nichts. Praktisch hat sich im Verhältnis David gegen Goliath allerdings alles in Intels Richtung verschoben. So sehr, dass Intel mittlerweile es gar nicht mehr nötig hat Neues zu entwickeln. -.-

Irgendwie wünsche ich es Sunnyvale. Habe ich schon immer. Doch glauben werde ich nicht mehr daran. Da ich hauptsächlich Linux nutze, kann ich selbstredend mit Grafikchips, die sich nach 1-2 Jahren selbst zerstören, weil es keine Treiber mehr gibt, weil ATI keinen Bock mehr hat, nichts anfangen. Und als SoC taugt eigentlich nur das ARM-Zeug. Also entweder war ich früher dümmer. Oder einfach nur naiv.

Nachdem ich so ein bisschen auf hohem (1st-World-) Niveau gerantet habe, Ryzen soll es jedenfalls jetzt richten. Aber erst 2018 für Desktops.

Bis dahin, die Hightech-Taiwanesen von Asus werden die ersten sein, die die revolutionäre neue AMD-CPU in einem Laptop verbauen. Der sieht dann so aus und richtet sich selbstredend erstmal an die Zockerseelen dieser Welt:

Oben: Asus ROG Strix GL702ZC, Bildquelle: Asus, Taiwan

Das Teil ist ein schönes, düsteres Biest und wurde auch schon gebenchmarkt. Letzten Monat von den Leuten von bit-tech.net. Hier die Specs im Überblick:

* Ryzen 7 1700 8-Core-CPU, 3-3,7GHz

* ATI Mobile Radeon RX 580 2GHz CPU mit 4GB DDR5 RAM

* 17,3“-Display, FHD-Technologie, unterstützt FreeSync 2.0

* bis zu 32GB RAM möglich

* rot beleuchtete Gamer-Tastatur

* Preis noch nicht bekannt

Beim Preis würde ich nicht meckern, wenn dieser öffentlich wird: AMD ist bekannt dafür, eines der besten (wenn nicht das beste) Preis-Leistungsverhältnis auf dem Markt zu bieten. In Sachen Effizienz waren sie schon immer Streber. Und oft auch besser wie Intel. Das hat nur niemanden gejuckt. Dumm kauft eben teuer.

Kleiner Nachtrag: weiter oben habe ich gesagt, es war naiv, was ich früher so über CPUs dachte. Aber nicht, weil ich „für AMD“ und generell „gegen Intel“ war. Sondern weil ich mich so ein bisschen mehr mit Prozessoren beschäftigte. Es ist ein kleines Hobby geworden, Benchmarks, Studien und Architekturen, sowie Geschichte nachzulesen. Und lasst mich euch ein kleines, wissenschaftliches CPU-Geheimnis verraten: _jede_ CPU ist scheiße, die um Performance zu liefern, viel RAM braucht. Scheiß Wissenschaft, nicht!?

Stichwort Budget-Smartphones: wer aus irgendeinem Grund keine Custom ROM für sein Android-Gerät findet, muss nicht sofort verzweifeln. Generell ist es ein gutes Zeichen für ein Betriebssystem, wenn es auf möglichst viel Hardware zurückgreifen kann. Bekannte Hersteller heute, die „generic devices“ anbieten, also Smartphones mit identischem Chipsatz, sind etwa Wiko aus Frankreich, Cubot aus China oder Kazam aus Großbritannien. Häufig verzichten diese Hersteller auf populäre, teurere SoCs von Qualcomm und setzen die mittlerweile nicht minder leistungsfähigen MediaTek-SoCs ein.

Ob das eigene Gerät vom Mangel an Custom ROMs betroffen ist lässt sich schnell herausfinden: man installiert TWRP aus dem Play Store und gibt seinen Hersteller in der App ein. Findet die App den Hersteller nicht, war es das mit einer Custom Recovery für euer Gerät. Findet die App den Hersteller, aber euer Gerät nicht, gilt das selbe. Eine Custom Recovery ist jedoch eine _der_ Grundvoraussetzungen um das Gerät mit ROMs zu versorgen. Fehlt diese, lohnt es sich davon Abstand zu nehmen eine zu installieren die man irgendwo im Netz findet, es wird nichts Brauchbares durch eure Experimente herauskommen.

Was aber tun, wenn man das Gerät trotzdem modden und personalisieren will? Hier kommt das „Xposed Framework“ ins Spiel. Xposed lässt euch Module downloaden, die auch nichts anderes als Apps sind. Doch diese Module lassen euch eure Geräte in einer Tiefe modifizieren, dass diese am Ende von einer Custom ROM kaum mehr zu unterscheiden sind. Eines der umfangreichsten und populärsten ist z.B. GravityBox. Dieses Modul allein ist schon wert, dass man Xposed auf seinem Gerät ans Laufen bringt, die Einstellungen sind in etwa so umfangreich wie wenn ihr die Einstellungen und die Massen an Tweaks von Cyanogenmod/LineageOS her kennt.

Wie ihr Xposed installiert, ohne Recovery und ohne TWRP, will ich hier kurz erläutern.

WICHTIG: euer Gerät _muss_ gerootet sein! Egal wie ihr das macht, ob per ADB, das zwielichtige KingRoot oder sonstwie, ein Android-Gerät ohne Root ist nichts wert. Da hilft auch das günstigste SoC nichts.

Anleitung für Xposed-Installation:

- 1. Installiert FlashFire [root] aus dem Play Store von Chainfire. Dieses Tool lässt euch ZIPs ohne Custom Recovery flashen. Benötigt, selbstredend, root-Rechte

- 2. ihr braucht die ZIP des Xposed Framework. Wählt eure Android-Version hier aus (sdk21 für KK, sdk22 für LP, sdk23 für MM), danach eure Architektur, das wird meist ARM sein. Ganz unten findet ihr dann die neueste Version des Frameworks, derzeit v87 vom November 2016. Diese ZIP auf den Telefonspeicher verschieben

- 3. besorgt euch die APK der Xposed-App: hier der XDA-Thread. Die App ist frisch aus der Testphase raus und befindet sich derzeit in einer stabilen Version 3.1.1

- 4. Jetzt wird gekocht! Öffnet Flashfire und klickt auf das rote „+“ unten rechts.

Dort wählt ihr dann den Menüpunkt „Flash ZIP or OTA“.

Navigiert zu eurer Xposed-ZIP-Datei.

Klickt in Flashfire nun unten auf Flash!. Setzt den ersten Haken. Das Grundgerüst wird installiert. Es dürfen keine Fehlermeldungen kommen. Kommen doch welche, versucht andere Haken zu setzen oder lasst diese ganz weg. Sollten Fehlermeldungen kommen wird üblicherweise nichts zerstört, das Framework installiert sich einfach nicht - 5. Installiert die XposedInstaller-App. Startet danach das Gerät neu

- 6. wenn ihr nach dem Neustart die App das erste Mal öffnet, klickt kurz die Meldung weg und schaut, dass ihr einen grünen Haken seht. Danach könnt ihr links unter Downloads ein Modul installieren, wie erwähnt ist GravityBox dann eigentlich ein Must-Have

- Fazit: als goldene Regel gilt, wer Xposed nutzt, der braucht keine Custom ROM mehr und umgekehrt. Die zwei vertragen sich nicht und es ergibt auch keinen Sinn Xposed unter einer Custom ROM zu installieren. Das Xposed Framework stellt euch vielmehr auf dem Android-Gerät die Funktionalität einer Custom ROM durch herunterladbare Module zur Verfügung. Etwa wenn, wie erwähnt, keiner Lust hatte eine ROM zu basteln oder es in TWRP einfach kein Interesse von Seiten der Entwickler gab

Die Vielfalt an Android-Geräten dürfte in Zukunft wohl eher weiter zu- als abnehmen. Nicht immer werdet ihr für diese Geräte eine passende ROM finden, eine zu bauen erfordert unvorstellbar viel Aufwand, frisst Zeit und andere Ressourcen. Der oben erwähnte Test mit TWRP ist hier ein guter Anfang um herauszufinden, wie populär euer Device ist. Das trifft auch auf Tablets zu.

Mit diesem Beitrag wollte ich zeigen, dass es aber mittlerweile sehr mächtige Alternativen gibt, die eben nicht mal mehr eine Custom Recovery erfordern. Die Anzahl der Module für das Xposed Framework ist unvorstellbar riesig, man wird förmlich erschlagen, wenn man sich das erste Mal durch diese Liste scrollt. Ab Kitkat, also Android 4.4, werdet ihr sehr gute Karten haben viele Mods zu finden. Da sollte für jeden etwas dabei sein. Meines Erachtens ein MUSS ist das erwähnte GravityBox. Damit dürften die meisten Gelüste bereits abgedeckt sein. Probiert diese Module einfach aus, das Einzige, worauf ihr achten müsst ist, dass diese mit eurer Android-Version kompatibel sind.

Viel Spaß beim Modden, ihr cyberpunks! 😎

Aufgrund von Missbrauch ist es seit Juli 2015 leider nicht mehr möglich BOINC-weit gültige Teams zu erstellen. Mit einer netten Email an David Anderson ist mir das im September letzten Jahres aber doch gelungen.

Ich möchte alle Cyberpunks herzlich auffordern dem Team beizutreten, sofern sie bei mindestens einem BOINC-Projekt mitrechnen, hier der Link:

https://boinc.berkeley.edu/teams/team_display.php?teamid=4538.

Ist ganz klassisch gemeint, für jeden, der sich und seinen Lebensstil dieser Bewegung in irgendeiner Weise verbunden fühlt.

Seit September tröpfeln nun die BOINC-Projekte ein, wo man das neue Team auswählen kann: so gehören bereits Einstein@home, Sixtrack, MilkyWay@home, POEM@home und viele andere dazu. Meine Hoffnung ist, dass da noch mehr kommt, aber dafür muss so ein Team auch erst einmal wachsen.

Fühlt euch eingeladen!

English version:

Since July 2015 it’s not possible anymore to create BOINC-wide teams due to abuse. Sending a kind Email to David Anderson, however, I was able to create such a new team.

For all the cyberpunk BOINC participants out there, please feel invited: https://boinc.berkeley.edu/teams/team_display.php?teamid=4538.

Several projects already let you select the team, e.g. Einstein@home, Sixtrack, MilkyWay@home, POEM@home, among others. Over time new projects add the team manually or automatically.

Happy crunching!

Südkorea ist mir jetzt nicht gerade bekannt als ein Land, das oft auf den Panik-Knopf drückt. Gut, man hat einen durchgeknallten Nachbarn im Norden, der auf Der Bombe sitzt, doch bisher war der einfach zu blöd, das Ding („the gadget“) richtig zu zünden. Und auch bei explodierenden Smartphones wie dem Note 7: als das Flugzeugverbot dann kam, baute man einfach Umtauschhäuschen auf Flughäfen auf und umging, pardon, löste somit dieses Problem.

Beim Thema Alpha Go, einem Computer-Programm von Google, das den Weltklasse-Spieler Lee Sedol im „Go“ bezwang im März, verstanden die Südkoreaner aber dann keinen Spaß mehr: die Russen verloren ihr geliebtes Schach in den 90ern, die Asiaten nun ihr 2.500 Jahre altes Go. Jetzt. Reicht’s!

Anders ist die Reaktion kaum zu erklären, wieso Südkorea, wo diese Aktion in einen regelrechten AlphaGo-Schock mündete, nun 860 Millionen Euro in einen nagelneuen Fond pumpt, um auf dem Feld KI, also Künstliche Intelligenz, nicht abgehängt und vollends totgetreten zu werden.

Und hier geht es nicht nur um die extrem hohe Summe, die zur Verfügung stehen soll: das neue Institut soll privat wie öffentlich sein. Samsung hängt mit drin. LG. Hyundai. Die Suchmaschine Naver. Das sind nicht nur asiatische Schwergewichte, sondern Weltkonzerne. Spätestens hier wird klar, wie ernst man die Lage nimmt, wie schwer man getroffen wurde, welches Know-How und welche Technologie(n) man benötigen wird, um Genesung an der asiatischen Seele zu leisten. Gegen eine Maschine zu verlieren scheint dort ein No-Go zu sein. Bei uns wird jeder müde belächelt, wenn er sagt, erneut hat die Menschheit ein Spiel an eine Maschine verloren. Im Westen wurden nach Kasparows Niederlage 1997 einfach größere und schnellere „Deep Blue“s gebaut. Heute trägt fast jeder so einen „Deep Blue“ in der Hosentasche herum und spielt süchtigmachendes Pokémon.

Der Philosoph in mir drin sagt: „Was regt’s euch so auf, es ist doch erneut nur Dualismus, Schwarz gegen Weiß, 0 gegen 1, an oder aus, etwas, worin die Amerikaner eben Weltklasse sind und sie sind auch noch so doof und legen Wert darauf!“. Der Wissenschaftler aber sagt: „Spätestens wenn Google dann auch noch mit seiner KI dein geliebtes „Starcraft II“ gepackt hat, eines der besten und komplexesten Echtzeit(!)-Strategie-Spiele der Welt, solltest du aufgewacht sein, mein Freund!“

Und genau das ist es eigentlich: richtig rezipiert und ausgiebig darüber diskutiert wurde nicht, als 1997 „Deep Blue“ Kasparow im Schach bezwang. Weder im Freundeskreis, noch in der Familie. In der Schule war man irgendwie „besorgt“, was das jetzt zu bedeuten habe, aber wollte oder konnte das auch nicht kommunizieren. Schließlich ist Schach ja so alt und Russland und IBM so weit weg, außerdem wissen wir alle nicht genau, was eine „AI“ eigentlich ist. Kollektives Schweigen, ein Raunen aus der Ecke, die Schach verstanden und verinnerlicht hatten. Ich muss dann später auch ins Reisebüro, mit Papa den Skiausflug nach Ischgl buchen und bin dann mal weg. So oder so ähnlich. Sie nannten es „Alltag“ oder „Realität“.

Die Asiaten, finde ich, machen sich da weniger vor. Die Ankündigung zur Gründung eines neuen Instituts kam nur 48h nach der 1:4-Niederlage von Sedol. Präsidentin Park Geun-hye, die ja gerade wegen ihrer Voodoo-Priester-Besten-Freundin und Küngelei aus dem Amt gejagt wird, fand die richtigen Worte und sprach davon, „künstliche Intelligenz kann ein Segen für die menschliche Gesellschaft sein“ und dachte wahrscheinlich genau das Gegenteil. Sie sieht die KI als die „4. Industrielle Revolution“, was erfrischend klingt, wer aus einem Land kommt, wo Merkel-Neuland herrscht. Und sprach davon „der AlphaGo-Schock zwang uns dazu die KI als essentiell wichtig zu betrachten, bevor es zu spät ist“. Meine japanischen Freunde nur so: „häh!?“ Ja, sie hat sicherlich „Ghost in the Shell“ aus 1995 einfach vergessen. Die Hollywood-Fans meinten nur: WTF. Ja, „The Matrix“ aus 1999 war scheinbar auch nicht so ihr Ding. Wurde uns aber 1995 bereits aus Japan erzählt. Nun, was soll ich dazu noch beitragen, da ich „Welt am Draht“ aus 1973 kenne? Eben. Es ist Politik, wie langsam die Mühlen hier mahlen und wann ein Groschen endlich mal fällt; ich bin mir sicher, der Unmut der Bevölkerung auf die politische Kaste muss von irgendwoher kommen. Solch ein hartnäckiges Phänomen erscheint nicht über Nacht. Wenn für erwachsene Gebildete „Realitätsflucht“ das Einzige bleibt, woran sie sich noch ergötzen können, brauchst du dich nicht wundern, dass letzten Monat der dümmste Bonze der Welt auch mal Präsident werden durfte.

Was bleibt abschließend zu sagen? Man muss es beobachten, finde ich. Der Westen hat sich 1997 nicht groß darum gekümmert, was da mit dem königlichen Schach passiert war. Da „Go“ ungleich komplexer und schwerer zu spielen und zu beherrschen ist, ist das Thema nicht mal richtig vergleichbar. 2016 ist 1997 fast nicht mehr existent. Doch was genau geschieht hier eigentlich, im Hier und Jetzt? Wo stehen wir, wo soll es hingehen? Was findet hier genau statt, wenn künstliche Intelligenzen reale übertrumpfen? Am Ende wird man es für die gesamte Menschheit als Segen sehen, was dieses Jahr mit der asiatischen Seele passierte. Bitte lösen Sie nun dieses Problem! Willkommen. Im Club!

Auch die ESA macht in CPUs:

[via]

Oder präziser: lässt machen, der GR740 wird von Cobham Gaisler aus Schweden entwickelt und von STMicroelectronics aus Frankreich gefertigt.

Wofür ist er gut?

Damit Projekte wie Schiaparelli nicht wie Steine vom Mars-Himmel fallen. 😉

Nee, jetzt im Ernst: die ESA lässt diese CPUs extra anfertigen, weil die Chips von AMD, Intel, Qualcomm, DeinHerstellerHier im Weltall nicht bestehen würden. Die Strahlung wäre einfach zu hoch und zu stressig.

Die LEON4 stammen noch aus den grellen 90ern, der GR740 hier, oben schön abgebildet, ist ein Quadcore aus eben diesen Mikroprozessoren.

CPU-Pr0n! I ♥ it! Und eben: Wir. Sind. Europa. Racist NASA has no home here. We don’t want them. Period.

ATLAS@home gehört zu den anspruchsvolleren BOINC-Projekten: auch hier ist zwingend eine virtuelle Maschine erforderlich, um am Projekt teilnehmen zu können, die permanent viel über das Internet kommuniziert. Ferner lässt sich noch über eine spezielle XML einstellen, ob man mit nur 1 CPU oder mehreren rechnen möchte. Das sind Hürden, die für Newbees erst einmal genommen werden müssen, also zwingend über Online-Recherchen. Ist man hier durch, was oft nur über Herumexperimentieren gelingt, belegt das Projekt permanent 2,2GB RAM. Pro CPU, wohlgemerkt.

Das erklärt vielleicht so ein bisschen, warum ich hier innerhalb weniger Wochen zum „Nutzer des Tages“ deklariert wurde:

Vier Wochen den PC kontinuierlich rechnen lassen genügte für diese Ehrung.

Als Goodies bekommen Nutzer auch hier Badges: etwa für wie lange man dabei ist, wie viele Credits man beiträgt, etc.

Richtig cool wird es bei der mitgelieferten Grafik: über „Ansicht“ -> „Erweiterte Ansicht“ -> „Aufgaben“-Reiter -> hier links bei „Grafik anzeigen“, öffnet sich im Browser, wie viele Kollisionen man bereits durchgeführt hat! Dafür klickt man einfach auf „Your Contribution“. Partikelkollisionen von zuhause aus, ahoy!

Ich kann jedem CPU-Cruncher empfehlen hier mitzumachen: schließlich war es ATLAS am CERN, der das Higgs-Boson fand, dieses „gottverdammte Teilchen“, das allen anderen seine Masse verleiht. Und da vLHC@home leider eingestampft und jüngst mit LHC@home gemerget wurde, werden die Mitmachprojekte immer weniger. Da es einige Hürden gibt bei ATLAS@home, wird man hier jedoch sehr schnell als „Nutzer des Tages“ erwähnt.

Fazit: anspruchsvolles Technikungetüm von Projekt, was man hier crunchen kann. Aber ein geiles Gefühl für „unser“ CERN zu rechnen wie auch einen „kleinen ATLAS“ zuhause zu haben! 🙂

Ich hatte ja vor längerer Zeit mal erwähnt, dass ich es gut finde, durch Distributed-Computing-Projekte mehr für Europa rechnen zu lassen. Mit BOINC geht das ja mittlerweile extrem gut, man muss sich eben ein bisschen einlesen und die Institutionen finden.

Von unserer Primus-Foschungsstätte CERN gibt es sogar zwei Projekte, wo man selbst mit seinem Rechner mitmachen kann: Eines ist das SIXTRACK, es ist das einfacher einzurichtende der beiden und wird wie die meisten BOINC-Projekte direkt über den Client hinzugefügt, wenn man vorher eine EMail-Adresse und ein Passwort hinterlegt hat. Das war’s auch schon! Happy crunching!!

Die Krönung ist aber vLHC@home, auch bekannt unter dem alten Namen Test4Theory, wo man mit Hilfe von VirtualBox (zwingend notwendig hier) auf dem eigenen Rechner quasi seinen eigenen Teilchenbeschleuniger betreibt.

Fassen wir nun kurz zusammen, was man braucht, um vLCH@home zu betreiben:

1. einen vLHC@home-Account, hier klicken, um diesen zu erstellen

2. den BOINC-Client natürlich

3. einen PC (Betriebssystem egal) mit mindestens 512MB RAM, Internetverbindung und mindestens 9GB(!) freiem Speicherplatz, den das Projekt benötigt

4a. VirtualBox ist ein Muss

4b. eventuell noch das VirtualBox Extension Pack, hier der Link, wo ihr euch das passende zu eurer VirtualBox-Version aussuchen müsst

Dieses Pack hat in meinem Fall dazu geführt, dass der BOINC-Client, und damit auch vLHC@home, eine eigene virtuelle Maschine anlegen kann. Diese heißt etwa boinc_30b2eng324h oder so ähnlich und taucht auch in eurer Liste bei den anderen virtuellen Maschinen auf.

Das sind alles schon mehr Vorbereitungen, als einem lieb sein kann, aber nun verfügt ihr über die Voraussetzungen für vLHC@home.

Ihr fügt nun am Ende nur noch das Projekt über BOINC hinzu, füllt Email und Passwort aus und es passiert Magisches: Denn ab jetzt legt der Client die virtuelle Maschine automatisch an und der Rechner cruncht nun für das CERN! 🙂

Eine „Installationsanleitung“ findet man noch hier: http://lhcathome.web.cern.ch/test4theory/join-us. Ist die offizielle, aber leider wurde nichts von dem Extension Pack erwähnt. Das war bei mir ziemliches Try&Error und recht uncool am Anfang.

Das Projekt selbst ist erst 3 Jahre alt und da es etwas aufwendiger aufzusetzen ist, machen leider bisher nur wenige mit. Das führt aber dazu, dass man schnell Badges holt, ich bin innerhalb kürzester Zeit in die „Top 25%“ aufgestiegen und habe eine Anfrage aus Südkorea für Team-Crunching angenommen. Pretty cool, don’t you think?

Und bevor ich es vergesse: Wozu braucht man Teilchenbeschleuniger überhaupt und was macht so ein Ding!? Weißte Bescheid.

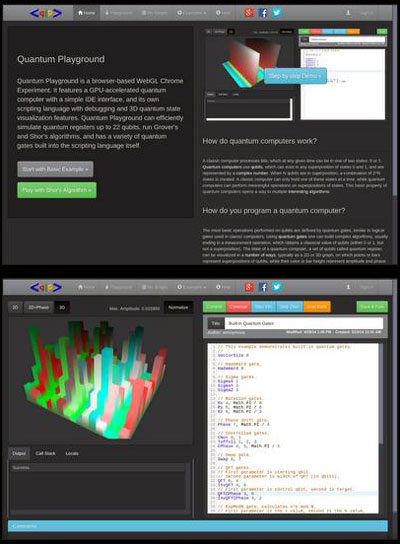

…vom großen Google erdacht, für uns zum Ausprobieren, läuft im Browser:

Da hatte wohl jemand zu viel Freizeit.

Was er kann: Wird mit der GPU betrieben, es sollen so 22 Qubits zum Schreiben, Debuggen und Teilen von eigenen Programmen zur Verfügung stehen.

Probiert es aus, hier hat noch niemand einen Plan, vielleicht habt ihr ja einen Geistesblitz:

http://chromeexperiments.com/detail/quantum-computing-playground/. [via]

Nehmt das mit dem „Experiment“ dort bitte wörtlich, mehr ist es leider nicht.

Eye-Candy gibt es aber umsonst: Es stehen Visualisierungen für eure Berechnungen in 2D und sogar 3D zur Verfügung. Das hat sich mit der GPU also bezahlt gemacht.

Und das Coolste, wovon ich bisher nie etwas gehört habe: Führt euren Code rückwärts aus! Yeah, githcir neseleg. I like!

1965 postulierte Intel-Gründer Gordon Moore, alle 18 Monate würde sich die Transistoren-Anzahl auf einem Prozessor-Chip verdoppeln. Damit lag er bereits von Anfang an komplett daneben, der Zeitraum musste auf zwei volle Jahre angehoben werden. Sechs Monate sind in der IT-Technik eine Ewigkeit.

Nun wollen es endlich die Gesetze der Physik, verglichen mit der Beobachtung von Moore Gesetze der Natur und damit die einzig wahren, dass dieser Trend einfach nicht mehr aufrechtzuerhalten ist. Transistoren baut man aus Atomen. Je kleiner die werden, um mehr und mehr Atome unterbringen zu können, erreicht man irgendwann, automatisch, den Punkt, wo man schlichtweg auf keine Atome mehr zurückgreifen kann.

Die Lösung: Das menschliche Gehirn.

Dieses ist zwar redundant (deshalb die vielen Neuronen) und verglichen mit einem Computer „langsam“, was die Aktionszeit von Neuronen betrifft. Aber es arbeitet ununterbrochen in parallelen Prozessen und sogar mit unterschiedlichen Regionen des Gehirns zur selben Zeit.

Ein Projekt namens SpiNNaker nimmt sich diese Arbeitsweise nun als Vorbild. Es steht für „Spiking Neural Network Architecture“. Es wird von Steve Furber an der Universität von Manchester geleitet und setzt sich das Ziel mit einer Million(!) ARM-CPUs (ARM ist sehr sparsam und recht leistungsfähig, weshalb die Architektur oft und gerne in Smartphones verbaut wird) den Prozess von parallelen Berechnungen künstlich nachzubilden. ARM-CPUs wurden nicht zufällig gewählt. Sie sind, ebenso wie unsere biologischen Neuronen, nicht die allerschärfsten Super-CPUs. Sie kommen jedoch, findet zumindest Furber, derzeit unseren Neuronen gerade deshalb am nächsten. [via]

Dass es dieses „Gesetz“ von Moore gab hat wohl dazu geführt, dass man sich mit dem Problem erst jetzt auseinandersetzt. Durch die Architektur der CPUs ist die Beobachtung von Moore logisch gewesen und wurde entsprechend automatisch erreicht. Hätte man sich bereits viel früher davon abgewandt, hätten wir heute viel mehr Architekturen und neue CPU-Ansätze, die es so schnell nicht geben wird. Man könnte sogar sagen, sich auf diese Aussage von Intel zu verlassen hat uns in der eigentlichen Entwicklung von CPUs Jahrzehnte zurückgeworfen. Das Los der eigenen Faulheit. Oder eben, in diesem Fall, der Entwickler und Firmen.

Weiterhelfen tut uns das alles heute nichts mehr, es gibt noch viel radikalere Ansätze, einen Ausweg zu finden. Einer ist der Verzicht auf das wertvolle Silizium. An der Universität Stanford rennt bereits ein „Karbon-Nanoröhren-PC„, wenn auch in einer sehr primitiven Version. Diese _könnten_ eine Art Übergang bilden, denn sie sind sehr energieeffizient.

Und dann gibt es natürlich noch die Entwicklung der Quantencomputer, über die auch hier bei Gizmeo gerne berichtet wird. Meiner persönlichen Meinung nach das bisher einzige Konzept, das nicht nur einen Übergang darstellen wird. Ein fähiger Rechner wird uns jedoch die nächsten 20(!) Jahre nicht zur Verfügung stehen. Das hat einen triftigen Grund: Quantenzustände ändern sich, sobald man mit ihnen interagiert. Dieses Problem muss aber gelöst werden, um Superzustände erhalten zu können, die mehr abbilden als diese schnöde 1 und diese ominöse 0.

Das ist schon ein Knaller:

„Auf 18 Seiten beschreiben Forscher der University of Massachusetts, der TU Delft und der Ruhr-Universität Bochum, wie man in Computerchips kaum zu entdeckende Hintertüren einbauen könnte.“ [via]

Das Original-PDF: http://people.umass.edu/gbecker/BeckerChes13.pdf.

Das ist genau die die Art von „Alien-Technologie“, die die Kryptographie-Experten derzeit ins Feld führen: Dass man es bei der NSA mit einem Gegner zu tun hat, der die Mittel, und auch das Geld, besitzt, solche Dinge in der Praxis anwenden zu können.

Lasst euch hier nichts vormachen: Das ist ein wichtiger Aspekt, aber eben nur einer. „Stealthy Hardware Trojans“ können ebenfalls in GPUs, WLAN-Karten, RFIDs, etc. verbaut sein. Es ist nur schwer, extrem schwer und deswegen dementiert das Intel auch vehement in dem Artikel, zu wissen, wo man suchen muss.

Ich kenne diesen Bruce Schneier nicht und ich weiß auch nicht, wieso das der einzige Experte aus dem Krypto-Bereich ist, der dauernd von den Hauptstrom-Medien zitiert wird. Aber ein Satz hat ihn schlagartig sympathisch gemacht:

„Ja, das ist eine Verschwörungstheorie. (sic) Aber ich bin nicht mehr bereit, irgendetwas auszuschließen. Das ist das Schlimmste am Verhalten der NSA. Wir haben keine Ahnung mehr, wem wir vertrauen können.“ [via]

Ich bin schon lange kein vehementer Verfechter mehr von AMD. Und Intel hier direkt anzugreifen ist eventuell unfair: Auch Apple baut Chips, Sony (Japan) und Samsung (Südkorea) ebenfalls und es gibt da noch die Dauer-Verdächtigen von Broadcom, etc. Das, was hier berichtet wird, ist Königsklasse-Hardware-Hacking. Man braucht Zugang zu Produktionsstätten, muss viel Knowhow mitbringen, eventuell noch einen gerichtlichen Beschluss. Und genau sowas macht die NSA. „Alien-Technologie“. Wieso sitzt du eigentlich noch vor einem Computer?

Quanten-Computer sind kompliziert und keiner rafft die Programmierung. Doch die Universtät Bristol (UK) hat vor jedem interessierten Menschen mit einem Webbrowser Zugriff darauf zu geben, über das Internet (der berüchtigten Cloud in diesem Fall), um eigene Algorithmen testen zu können. Hier der Bericht:

http://bristol.ac.uk/physics/research/quantum/qcloud/computer/. [via]

Das Problem hierbei war eigentlich immer: Firmen wie Google oder auch die NASA-Organisation forschen mit diesen komplizierten Maschinen, wo es keine Bits mehr sondern Quantenbits (qubits) gibt, die den Zustand 0 und 1 zur selben Zeit annehmen können, diese Ergebnisse aber nicht an die Öffentlichkeit lassen. Doch wenn das niemand wirklich testen kann/darf/soll, wie soll diese Quantenrevolution dann ohne erfahrene Coder stattfinden?

Der Clou ist, dass der Simulator für die Neuzeit-Programmierer bereits online ist: http://cnotmz.appspot.com/.

Lediglich die Verbindung zum Photonen-Chip fehlt noch, die wird am 20. September stattfinden.

Leider kann dieser Simulator nur ein 2-Qubit-Gerät abbilden. Der bringt nicht viel mehr als der eigene PC derzeit. Die Entwicklungen mit 6 oder auch 8 Qubits ist noch nicht sehr weit, sobald man das jedoch zum Laufen gebracht hat sollen diese Simulatoren ebenfalls online verfügbar gemacht werden.

Und keine Panik, wer hier jetzt nur Bahnhof versteht: Geht mir genauso. Eminent wichtig ist einfach der Ansatz, jedem Zugriff auf diese Technik zu geben. Am Ende kommt wahrscheinlich genau dadurch etwas Gutes & Nützliches dabei heraus.