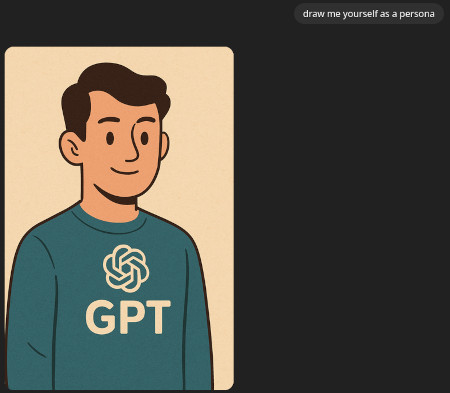

Irgendwann vor Version 5 habe ich ChatGPT gefragt, wie es sich selbst zeichnen würde:

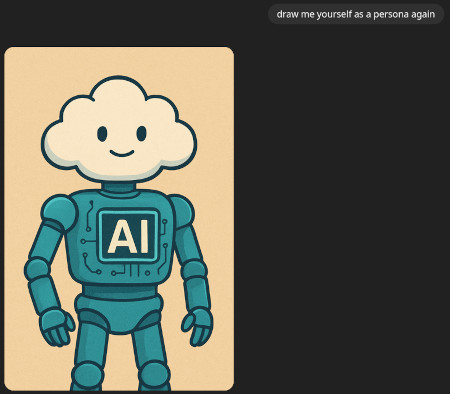

Den selben Befehl habe ich dann erst vor kurzem nach der Veröffentlichung der Version 5 erneut abgesendet:

Die Unterschiede, finde ich, sind schon krass.

Zum einen deckt sich das mit dem frühen Feedback der Nutzer:innen zur neuen Version, ChatGPT 5 fühle sich „kalt“ und „unmenschlich“ an. Zum anderen bin ich von Natur aus ein sehr neugieriger Mensch. Daher wollte ich direkt wissen, was der Bot selbst „denkt“, warum es hier diese großen Unterschiede gibt:

Great question! Both drawings are me, but they reflect two different ways of visualizing an AI persona:

The first version (human-like persona)

Looks like a friendly young man with brown hair and a teal sweater.

Designed to be approachable, relatable, and familiar, almost like a helpful colleague or friend.

Human traits make conversations feel warmer and more natural.

The second version (robot/cloud persona)

A robot body with a cloud-shaped head and “AI” circuits on the chest.

Symbolizes the non-human, digital essence of what I actually am.

More abstract and conceptual, reminding you that I live in the cloud and am built from data, not biology.

✨ So, the difference isn’t really a “change in me” but a shift in artistic interpretation:

One leans toward human familiarity.

The other highlights AI identity.

Mit der Version 5, dem neuesten Update seit 2022, hat uns OpenAI also die Möglichkeit genommen, den Bot als „Freund“ zu sehen.

Ergibt zunächst Sinn, denn plötzlich sind da ganze Wikipedia-Einträge zu düsteren mentalen Problemen wie „Chatbot-Psychose“, die wir so nie hatten. Kein Techunternehmen der Welt will mit Selbstmorden der eigenen Nutzer:innen in Verbindung gebracht werden. Zum anderen ist ein Bot eben tatsächlich nur ein Bot. Ein Thema was uns in der IT spätestens seit „Eliza“ beschäftigt; das war 1966. Dass Menschen Programme für menschlich halten ist also kein neues Phänomen, irgendwelche negativen Auswirkungen waren da durchaus zu erwarten. Überhaupt wenn man die Technik selbst nimmt, die in der Form des machine learning und LLMs aktuell nach wie vor höchstens in einer Betaphase läuft. Der Unterschied hier ist: man testet nicht mehr intern, sondern haut die Software einfach im unfertigen Stand raus und sagt „wird schon passen, irgendwie“.

Was auch auffällt ist, dass der Bot bei der Erklärung tatsächlich auch flunkert: nicht einmal 2 Wochen nach Veröffentlichung von Version 5 kam ein Update, was den Bot aufgrund der Nutzerbeschwerden wieder „wärmer und freundlicher“ machen sollte. Die Kälte war also absolut ein „change in me“ und hatte mit „künstlerischer Interpretation“ rein gar nichts zu tun. Die Kunst hier stammte von ChatGPT selbst, vor Version 5 und danach. Und ist ein sehr schönes Dokument, wie ein Bot sein Selbstbild erstellt (wenn es sowas überhaupt gibt). Und auch permanent selbst modifiziert. Egal was wir davon halten. Gesundes Hinterfragen kann da helfen.